如果防止自己的网站被搜索引擎收录

1、在网站的根目录下创建一个名为“robots.txt"的文本文件。实现这一步之后,任意一个搜索引擎访问自己的网站时,都会首先查找该文件,然后它就会根据这个文件的内容,来确定它访问的权限和范围。网站的目录结构如图所示。

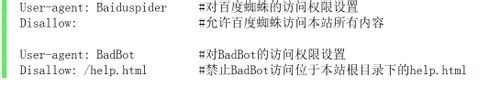

2、结合网站的内容,编写“robots.txt”文件的内容。我们要实现的目标是允许百度访问本站所有内容,对于BadBot,则主允许其访问或收录位于本站根目录下的help.html文件。据此编写的"robots.txt"文件内容如下:

3、过段时间之后,可上网搜索自己网站上相应内容,验证一下看搜索引擎是否按照robots.txt 文件所描述的权限进行相应的访问。

1、“robots.txt”文件包含一条或多条记录,这些记录通过空行分开(以CR、CR/NL、or NL作为结束符),每一条记录的格式如下所示:

“<field>:<optionalspace><value><optionalspace>”

在该文件中可以使用#进行注释,具体使用方法和UNIX中的惯例一样。该文件中的记录通常以一行或多行User-agent开始,后面加上若干Disallow行。

2、User-agent:该项的值用于描述搜索引擎机器人robot的名字。在“robots.txt”文件中,如果有多条 User-agent记录,说明有多个robot会受到该协议的约束。所以,“robots.txt”文件中至少要有一条User- agent记录。如果该项的值设为*(通配符),则该协议对任何搜索引擎机器人均有效。在“robots.txt”文件 中,“User-agent:*”这样的记录只能有一条。

3、Disallow:该项的值用于描述不希望被访问到的一个URL,这个URL可以是一条完整的路径,也可以 是部分的,任何以Disallow开头的URL均不会被robot访问到。

4、任何一条Disallow记录为空,说明该网站的所有部分都允许被访问,在 “/robots.txt”文件中,至少要有一条Disallow记录。如果“/robots.txt”是一个空文 件,则对于所有的搜索引擎robot,该网站都是开放的。