如何在Linux环境下进行Hadoop环境的配置?

1、打开三台虚拟机Master、Slave1、Slave2;

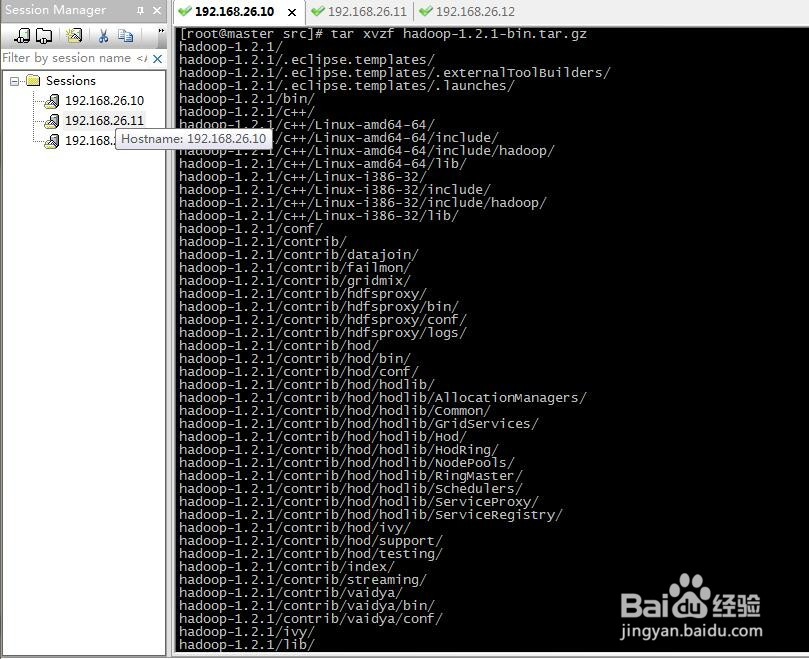

2、在Master节点中,解压Hadoop文件;

即输入命令:

cd /usr/local/src/;

ls

tar xvzf hadoop-1.2.1-bin.tar.gz

如下图所示,Hadoop压缩文件则解压成功。

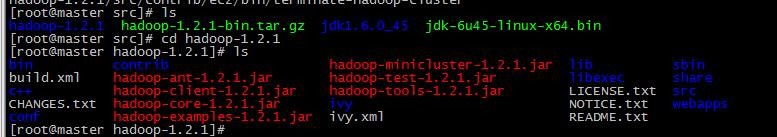

3、解压成功后,src目录下将新生出hadoop-1.2.1目录;

4、进入hadoop-1.2.1目录,新增一个文件,用来存放之后的临时文件;

输入命令:mkdir tmp

5、接下来,将修改配置文件:

进入hadoop的配置文件中:

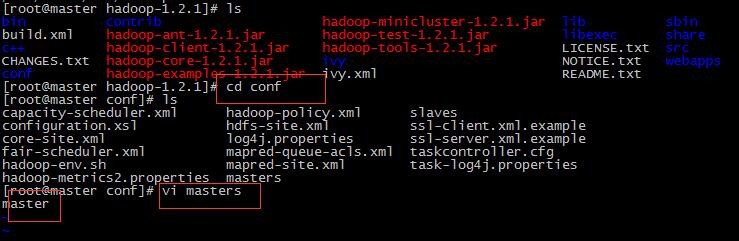

4、修改master配置文件,输入内容为master;

输入命令:

cd conf

vi master;输入master;

保存并退出;

6、修改slaves配置文件,输入两个节点名称;

输入命令:

vi slaves;

输入内容为slave1 slave2;

保存并退出;

7、修改core-site.xml配置文件;

输入命令:

vi core-site.xml;

配置tmp的路径、namenode的URI;

保存并退出;

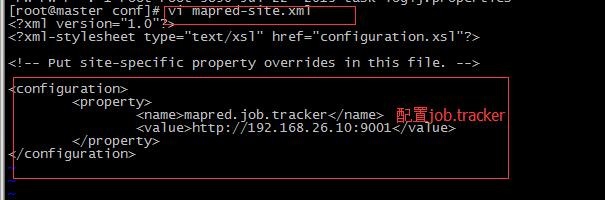

8、修改mapred-site.xml 配置文件;

输入命令:

vi mapred-site.xml

配置job.tracker的URI;

保存并退出;

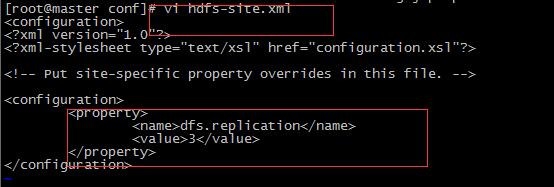

9、修改hdfs-site.xml 配置文件;

输入命令:

vi hdfs-site.xml,配置副本数;

保存并退出;

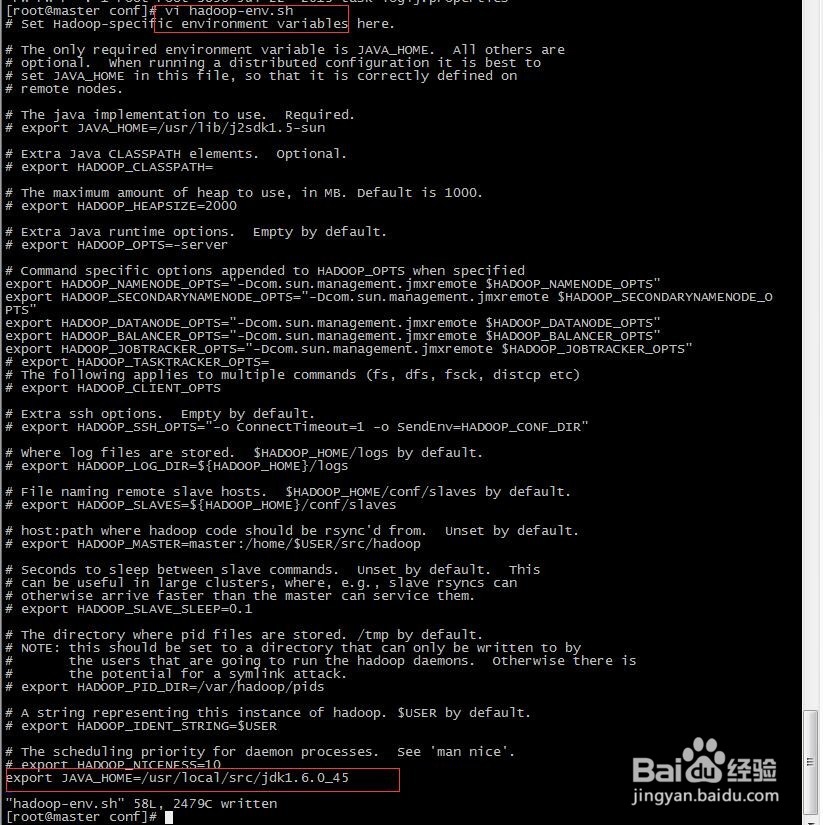

10、修改hadoop-env.sh 配置文件;

输入命令:

vi hadoop-env.sh ,配置Jdk的目录;

保存并退出;

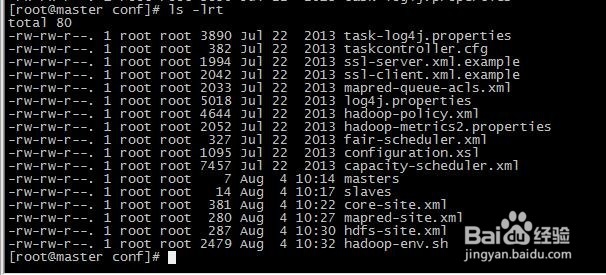

11、查看刚刚所有的修改的配置文件;

输入命令:

ls -rlt;

则配置文件一共需要配置六个文件。

12、在Master虚拟机中,对于Hadoop的配置已经配置完毕。

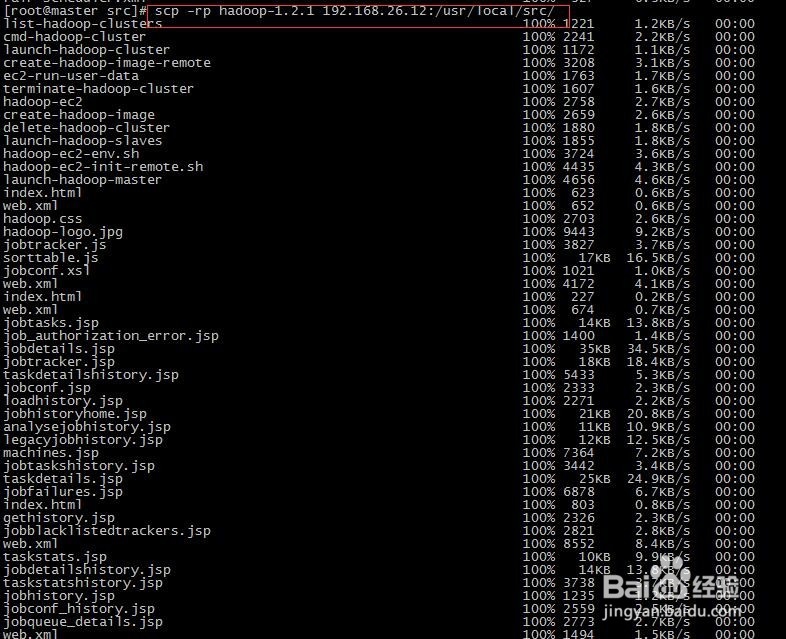

13、接下来,将hadoop文件依次拷贝到Slave1、Slave2虚拟机上;

输入命令:

scp -rp hadoop-1.2.1 192.168.26.11:/usr/local/src/

scp -rp hadoop-1.2.1 192.168.26.12:/usr/local/src/

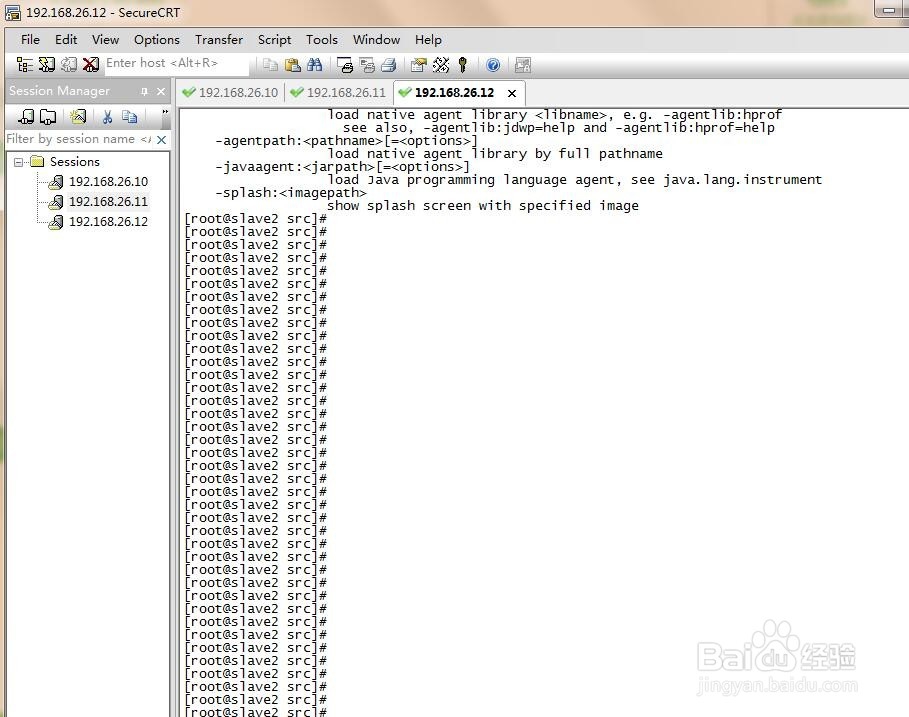

如下图所示,文件已经拷贝完毕。

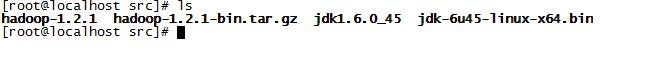

14、分别进入Slave1、Slave2的虚拟机上,查看/usr/local/src/目录下是否存在hadoop文件;

如下图所示,hadoop文件已经拷贝到Slave1和Slave2上。

15、综上所述,Master、Slave1、Slave2虚拟机对于hadoop的配置均配置完毕。