robot文件如何创建

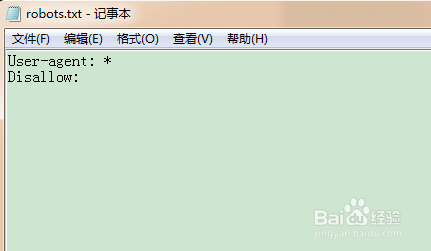

1、允许所有搜索引擎访问网站的所有部分

User-agent: *

Disallow:

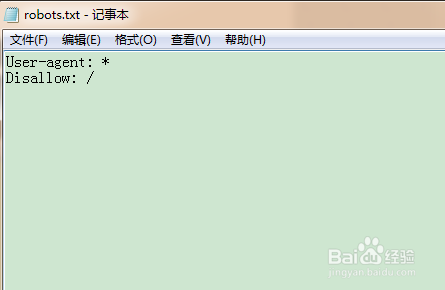

2、禁止所有搜索引擎访问网站的所有部分

User-agent: *

Disallow: /

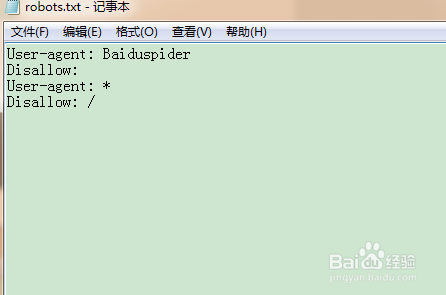

3、禁止除百度外的一切搜索引擎索引你的网站

User-agent: Baiduspider

Disallow:

User-agent: *

Disallow: /

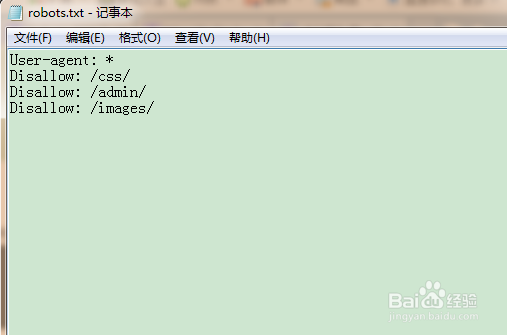

4、禁止蜘蛛访问某个目录(如禁止admin,css,images三个目录被索引)

User-agent: *

Disallow: /css/

Disallow: /admin/

Disallow: /images/

(注意三个目录需要分开写,一行写一个)

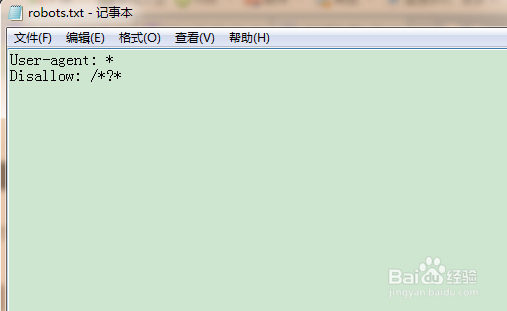

5、禁止索引网站中所有含有“?”网址

User-agent: *

Disallow: /*?*

还有很多相关设置,在这里无法做一一列举,需要大家触类旁通,以及下载一份较全的robotot文件语法。

1、Googlebot:谷歌蜘蛛

2、Baiduspider:百度蜘蛛

3、Yahoo! Slurp :雅虎蜘蛛

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。

阅读量:161

阅读量:135

阅读量:28

阅读量:77

阅读量:146