hadoop集成hive

1、进入$HIVE_HOME/conf/修改文件

cp hive-default.xml.template hive-site.xml

cp hive-env.sh.template hive-env.sh

修改$HIVE_HOME/bin的hive-env.sh,增加以下三行

HADOOP_HOME= --hadoop的home目录

export HIVE_CONF_DIR= --hive的conf目录

export HIVE_AUX_JARS_PATH= --hive的lib目录

生效文件:

source /hive-env.sh(生效文件)

2、修改$HIVE_HOME/conf/hive-site.xml

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

3、修改$HIVE_HOME/conf/hive-site.xml

(1)设定数据目录

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/usr/local/hive/warehouse</value>

</property>

(2)设定临时文件目录

<property>

<name>hive.exec.scratdir</name>

<value>/usr/local/hive/tmp</value>

</property>

(3)hive相关日志的目录

<property>

<name>hive.querylog.location</name>

<value>/usr/local/hive/log</value>

</property>

4、sqoop的安装与配置

(1)下载、解压:

tar -zxvf sqoop-1.4.4.bin__hadoop-2.0.4-alpha.tar.gz /root

cd /root

ln -s sqoop-1.4.3.bin sqoop

(2)配置sqoop:

vi ~/.bash_profile

export SQOOP_HOME=/usr/local/sqoop

export PATH=$SQOOP_HOME/bin:$PATH

5、测试环境:

(1)测试连接数据库并列出数据库:

sqoop list-databases --connect jdbc:mysql://localhost:3306/ --username root --password 123456

(2)将mysql中的表导入到hive中:

sqoop import --connect jdbc:mysql://localhost:3306/gwifi --username root --password 123456 --table think_access --hive-import -m 1;

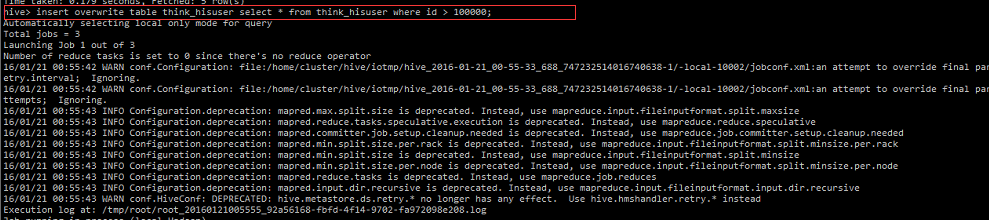

6、运行demo: