Spark的环境搭建(Linux/Ubuntu64)

1、一、Spark相关依赖软件的下载(Spark 2.4.5、Scala 2.12、Java 8)

更多版本介绍: http://spark.apache.org/docs/latest/

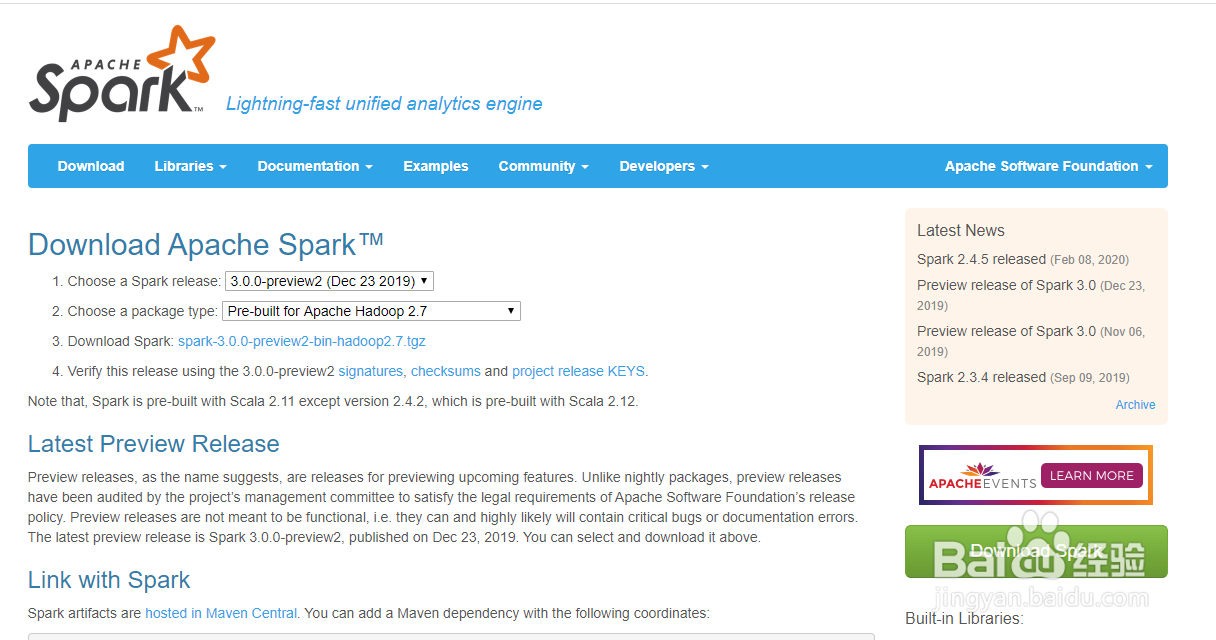

2、1.1、下载Spark

官网下载: http://spark.apache.org/downloads.html

3、在“Choose a Spark release”下拉框可以选择最近的其他版本,在“Choose a package type”下拉框可以选择集成Hadoop,之后单击“Download Spark”后面的链接进入下载页面

4、选择下载镜像

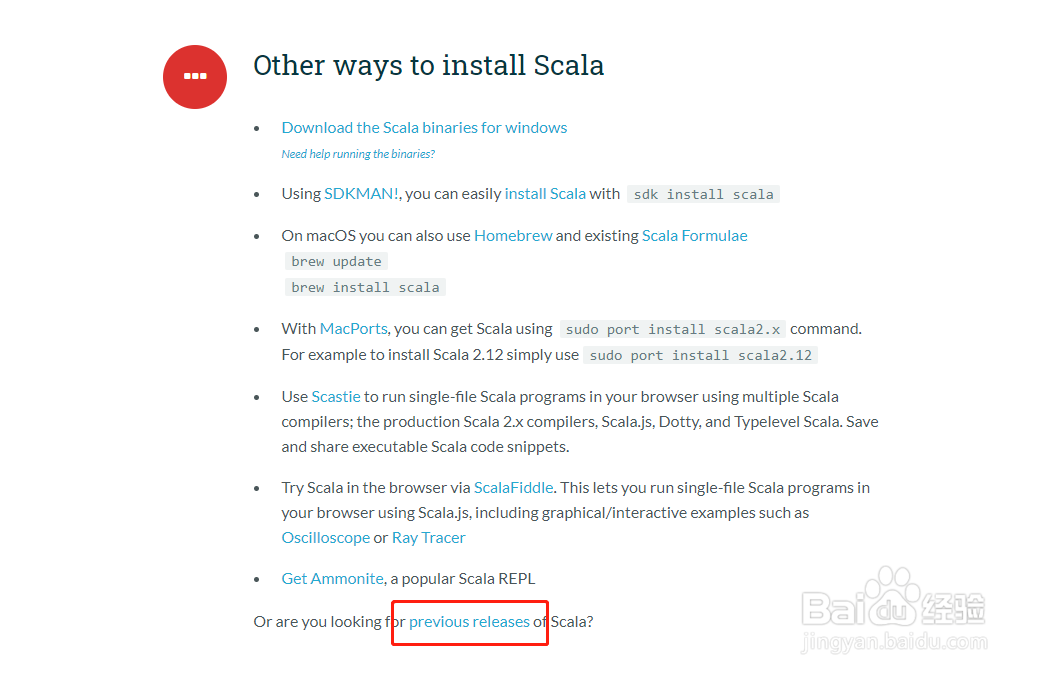

5、1.2、下载Scala

官网下载: https://www.scala-lang.org/download/

找到‘ previous releases’可以选择其他版本

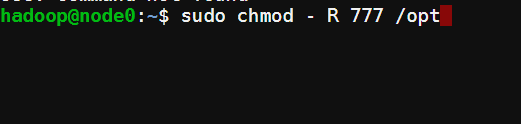

6、我们选择Scala 2.12.11

进入下载页面,在网页底端找到“Other resources”,因为这里以Ubuntu系统为例,选择tgz的压缩包类型,点击下载即可。游客也可以根据自己的情况来进行选择。

7、下载java 8

进入JDK下载页面,下载Linux 64版本的文件下载,选择压缩包类型tar.gz

8、二、Spark环境的配置

(安装SSH、SSH免密码登录、修改访问权限、修改profile文件、修改Spark配置文件)

9、2.1、安装SSH,配置免密码登录

参考我之前分享的经验:

https://jingyan.baidu.com/article/8275fc86d5014607a03cf6b7.html

10、2.2、修改访问权限

把上面下载的文件上传到Ubuntu

使用解压tar命令

tar -zxvf jdk1.8***

tar -zxvf spark-2.4.5-***

tar -zxvf Scala-2.***

按照自己下载的版本,自行补全,或者用“tab”键补全

11、这里我把这些软件都放在/opt目录中

sudo cp - R jdk1.8**** /opt

sudo cp - R spark-2.4.5-*** /opt

sudo cp - R Scala-2.*** /opt

12、修改/opt文件夹权限

sudo chmod - R 777 /opt

13、2.3、环境配置

java环境配置

(自行补全jdk版本)

export JAVA_HOME = /opt/jdk1.8.**

export CLASS_PATH = /opt/jdk1.8.**/lib

export PATH = $ PATH:$ JAVA_HOME/bin

14、Scala环境配置

export SCALA_HOME = /opt/Scala-2.12.***

export PATH = $ PATH:$ SCALA_HOME/bin

15、Spark环境配置

export SPARK_HOME = /opt/spark-2.4.5***

export PATH = $ PATH:$ SPARK_HOME/bin

16、配置完成后进行环境生效

重启系统,或者执行source命令

17、2.4、修改Spark配置文件

(1)复制摸板文件

进入配置文件夹

cd /opt/spark-2.3.5-****/conf #我已经把spark-2.4.5****重命名为spark,各位看需求自行操作,这里我就不演示

cp spark-env.sh.template spark-env.sh

cp log4j.properties.template log4j.properties

cp slaves.template slaves

18、(修改spark-env设置主节点和从节点的配置)

export JAVA_HOME = /opt/jdk1.8.** #添加java位置

export SCALA_HOME = /opt/Scala-2.12.*** #Scala位置

export SPARK_MASTER_IP = SparkMaster #主节点地址

export SPARK_WORKER_MEMORY = 4g #节点内存大小

export SPARK_WORKER_CORES = 2 #核数

export SPARK_WORKER_INSTANCES = 1 #节点实例数

19、(修改slaves设置从节点地址)

添加节点主机名称,默认为localhost

看自己具体情况