如何使用爬虫下载网站小说

1、首先import所需的库,urllib.request的urlopen和beautifulsoup.由于需要将内容写入到txt文件中,也需要import os库

2、输入文本写入路径,使用urlopen打开网址并用beautifulsoup解析.

3、打开网站源代码,找到小说地址,查看其所属区域块.

每个块都会有起始、终止符号,例如<div>...</div>,符号中间的部分是该块的内容,同时,每个块不是只有一个,需要其他标签定位等.

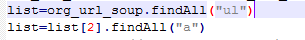

4、list是小说网址部分的内容href=子网址,由于源码内ul有3个,所需部分是最后一个,所以加上下标定位最后一个ul。

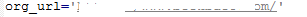

5、如步骤3中图片所示,网址的内容是不全的,前面省略了主网址。

为保证正确,需要打开该网址,查看主网址,在代码中重定义org_url.

6、内容的下载、写入部分代码如图.

第一个for循环是写入每章的内容.

第二个for循环写入该章的内容.

该部分也需要查看具体章节页面的源码.

最后关闭文件,进行保存.

1、运行该命令,代码正确后会显示如图.

可以看出文件正成功逐章下载。

2、打开保存的文件,会看到小说成功保存到文件中,如图.

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。

阅读量:165

阅读量:110

阅读量:115

阅读量:125

阅读量:131