robots.txt怎么写

1、写Robots,很多站长工具都是可以自动生成的,可以利用这些工具来写Robots。

2、写Robots之前,我们可以先登录网站的根目录,先整理好哪些文件夹不想背搜索引擎爬抓。

3、然后最后Robots.txt的写法如下。

# robots.txt

User-agent: *

Allow: /

Disallow: /admin

Disallow: /App_Code

Disallow: /App_Data

Sitemap:http://域名地址.com//sitemap.xml

其中:

Disallow后面的文件夹是禁止搜索引擎抓取的。

4、然后把内容复制到文本文档中,保存好,然后在把文档改成robots.txt

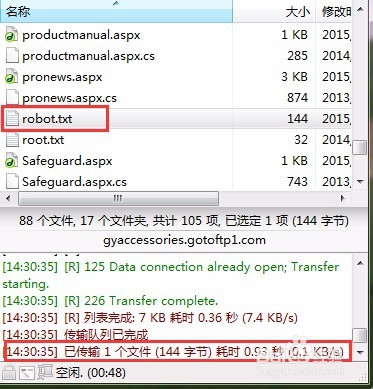

5、然后登录自己的网站ftp,把制作好的robots.txt文件复制到网站的根目录即可。

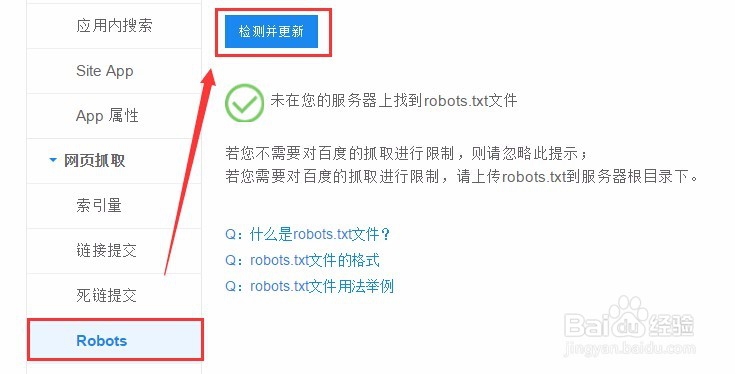

6、最后登录百度站长工具,检测是否提交成功,检测出robots.txt文件即可。

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。

阅读量:128

阅读量:176

阅读量:115

阅读量:36

阅读量:83