hadoop2.8安装教程

1、首先安装一个centos7并配置好java

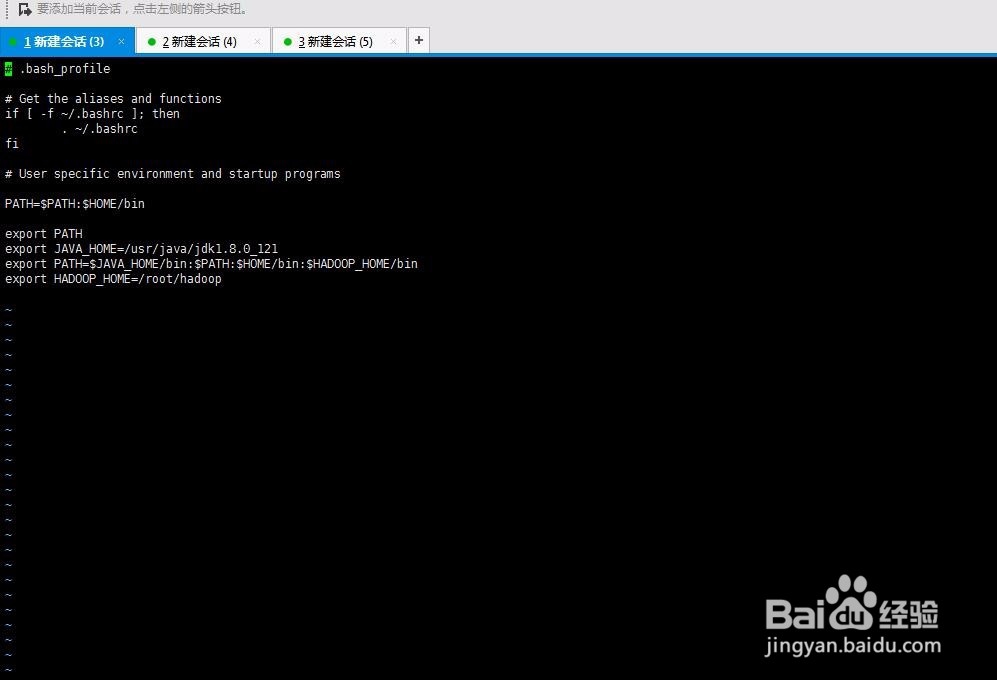

Java环境配置

我的java安装地址 /usr/java/ jdk1.8.0_121

编辑java环境 vi ~/.bash_profile

添加或修改

export JAVA_HOME=/usr/java/jdk1.8.0_121

export PATH=$JAVA_HOME/bin:$PATH

执行 . ~/.bash_profile 使变量生效

1、把下载好的hadoop解压出来。(我的地址在/roo目录,即完整地址/root/hadoop)

配置环境变量

vi ~/.bash_profile

export HADOOP_HOME=/root/hadoop

export PATH=$JAVA_HOME/bin:$PATH:$HOME/bin:$HADOOP_HOME/bin

执行 . ~/.bash_profile 使变量生效

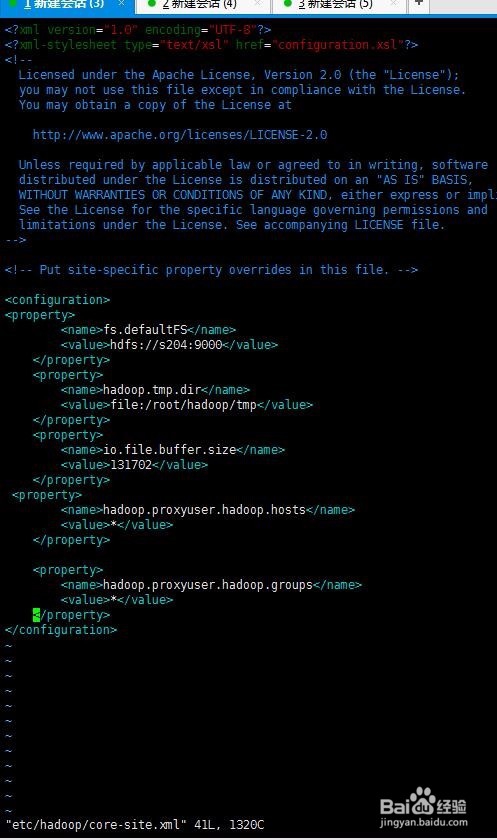

1、vim etc/hadoop/core-site.xml

在<configuration></configuration>中加入

<property>

<name>fs.defaultFS</name>

<value>hdfs://s204:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/root/hadoop/tmp</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131702</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.groups</name>

<value>*</value>

</property>

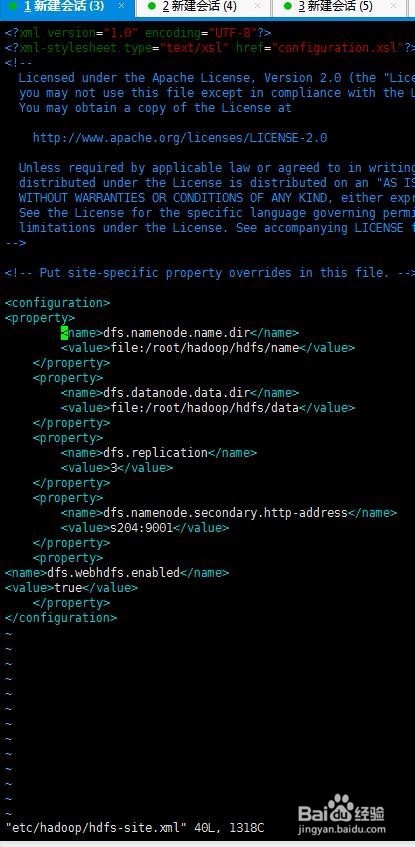

2、vim etc/hadoop/hdfs-site.xml

在<configuration></configuration>中加入

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/root/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/root/hadoop/hdfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>s204:9001</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

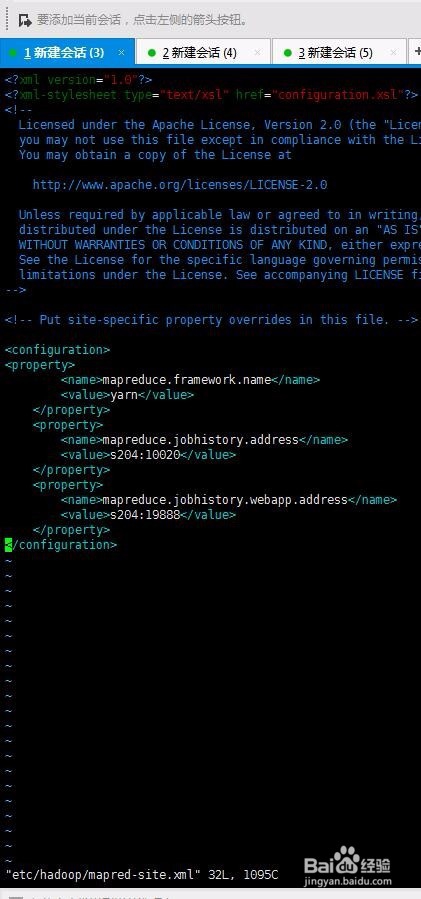

3、vim etc/hadoop/mapred-site.xml

在<configuration></configuration>中加入

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>s204:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>s204:19888</value>

</property>

4、vim etc/hadoop/yarn-site.xml

在<configuration></configuration>中加入

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>s204:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>s204:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>s204:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>s204:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>s204:8088</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>6078</value>

</property>

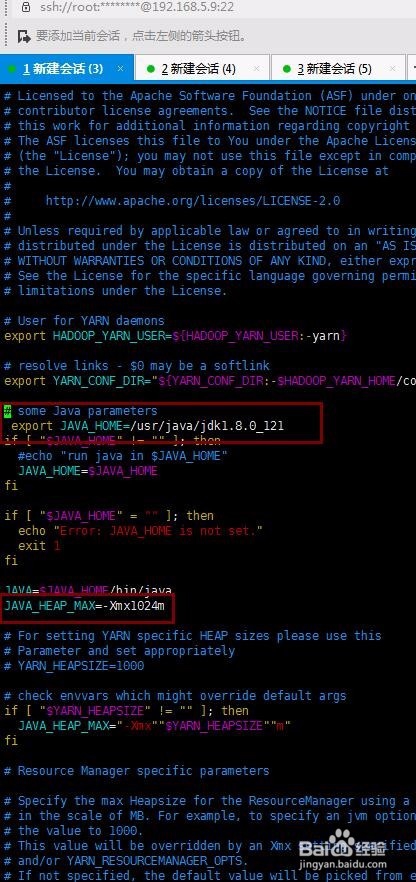

5、vim etc/hadoop/yarn-env.sh

中找到 export JAVA_HOME 去掉注释

编辑java地址 export JAVA_HOME=/usr/java/jdk1.8.0_121

找到JAVA_HEAP_MAX=-Xmx1000m

改为 JAVA_HEAP_MAX=-Xmx1024m

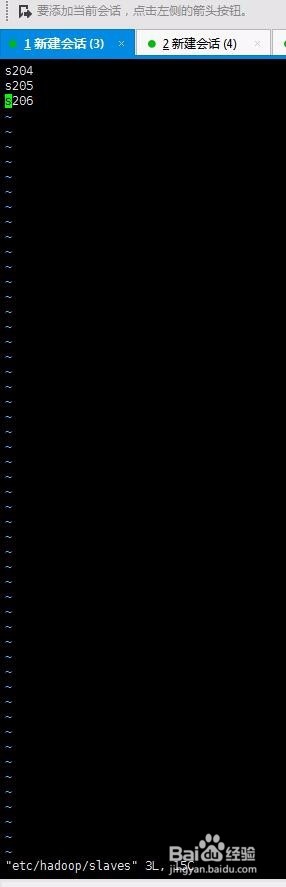

6、vim etc/hadoop/slaves

清空添加 s204

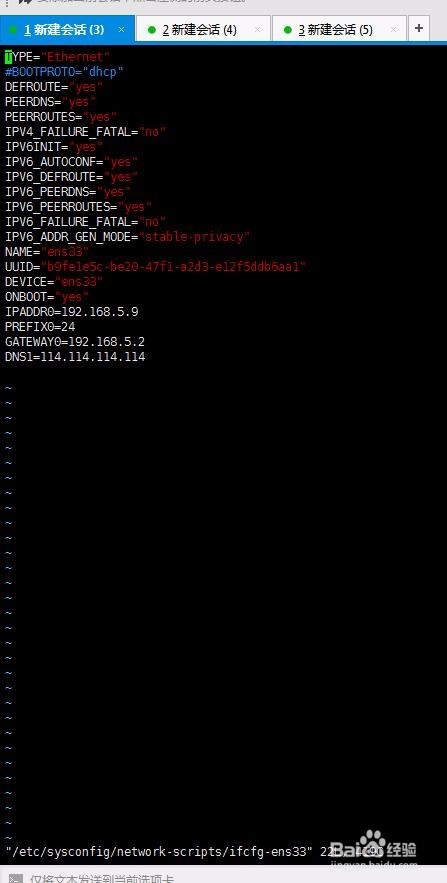

1、我这ip是 192.168.5.9

编辑网络固定ip

vim /etc/sysconfig/network-scripts/ifcfg-ens33

指定固定ip

TYPE="Ethernet"

#BOOTPROTO="dhcp"

DEFROUTE="yes"

PEERDNS="yes"

PEERROUTES="yes"

IPV4_FAILURE_FATAL="no"

IPV6INIT="yes"

IPV6_AUTOCONF="yes"

IPV6_DEFROUTE="yes"

IPV6_PEERDNS="yes"

IPV6_PEERROUTES="yes"

IPV6_FAILURE_FATAL="no"

IPV6_ADDR_GEN_MODE="stable-privacy"

NAME="ens33"

UUID="b9fe1e5c-be20-47f1-a2d3-e12f5ddb6aa1"

DEVICE="ens33"

ONBOOT="yes"

IPADDR0=192.168.5.9

PREFIX0=24

GATEWAY0=192.168.5.2

DNS1=114.114.114.114

然后重启网络 systemctl restart network

执行 ip add 查看网络ip是否和设定的一致

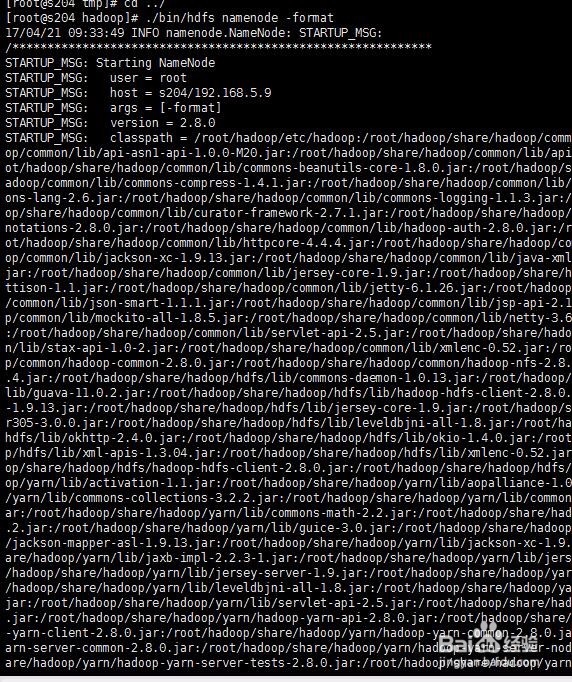

1、

进入/root/hadoop目录

执行编译

./bin/hdfs namenode –format

结果倒数第五行出现

Exiting with status 0 则为成功

然后启动

./sbin/start-all.sh

启动完毕执行./bin/hdfs dfsadmin –report 查看是否有节点

如果返回 无法连接则为启动失败

执行systemctl stop firewalld.service关闭防火墙 在浏览器输入s204:8088则可以看到hadoop界面

1、以上配置完毕后,关闭centos7

然后完全克隆,在新克隆的系统中,更改ip地址和主机名

其中hadoop配置文件

etc/hadoop/hdfs-site.xml 中 <property>

<name>dfs.datanode.data.dir</name>

<value>file:/root/hadoop/hdfs/data</value>

</property>

的file地址不能一样。

我这边三个地址分别为

file:/root/hadoop/hdfs/data

file:/root/hadoop/hdfs/data/205

file:/root/hadoop/hdfs/data/206

克隆完毕,配置文件和ip、主机名修改好后。在s204机器中编辑

vim etc/hadoop/slaves

加入

s205

s206

复制ssh令牌免密登录

例如复制到s205

scp ~/.ssh/authorized_keys root@s205:~/.ssh/

其他机器也一样操作

另外连个机器也要编译一下

然后在s204停止hadoop

./sbin/stop-all.sh

再次启动./sbin/start-all.sh

在浏览器就可以看到三个节点。